华为发布准万亿模型Pangu Ultra MoE模型架构和训练细节

作者:小微

发表于:2025年05月30日

浏览量:73801

图片来源于网络,如有侵权,请联系删除

(原标题:华为发布准万亿模型Pangu Ultra MoE模型架构和训练细节)

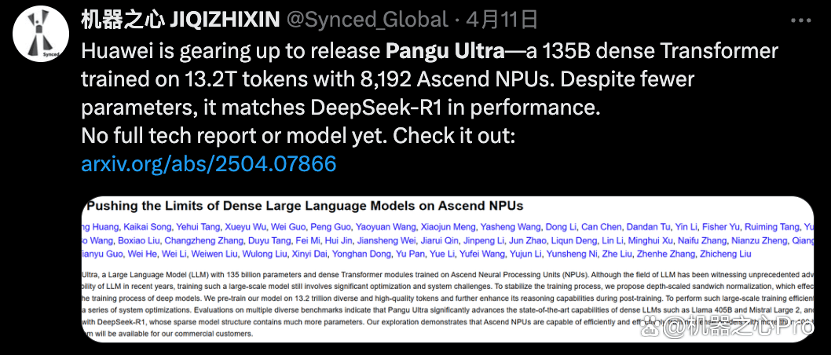

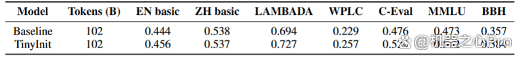

人民财讯5月30日电,近日,华为在MoE模型训练领域再进一步,推出参数规模高达7180亿的全新模型――盘古Ultra MoE,这是一个全流程在�N腾AI计算平台上训练的准万亿MoE模型。华为同时发布盘古Ultra MoE模型架构和训练方法的技术报告,披露众多技术细节,充分体现了�N腾在超大规模MoE训练性能上的跨越。

图片来源于网络,如有侵权,请联系删除

据悉,训练超大规模和极高稀疏性的MoE模型极具挑战,训练过程中的稳定性往往难以保障。针对这一难题,盘古团队在模型架构和训练方法上进行了创新性设计,成功地在�N腾平台上实现了准万亿MoE模型的全流程训练。